(文/陳濟深 編輯/張廣凱)

被稱為科技春晚的黃仁國際消費電子產(chǎn)品展覽會(CES)于1月6日正式開幕。

作為英偉達新年戰(zhàn)略和新品發(fā)布的勛點型英重要窗口,本次英偉達CEO依然身著去年同款亮面鱷魚皮衣登場,贊款中國加拿大pc28qq群發(fā)表了他在2026年的大模首場演講。

在CES開始前,偉達物理英偉達在社交媒體發(fā)布稱“(CES2026)不會發(fā)布新款GPU。押寶”這也是黃仁英偉達五年來首次不在CES發(fā)布新款GPU產(chǎn)品。

相比去年CES官宣了RTX50系產(chǎn)品,勛點型英本次演講中,贊款中國黃仁勛把重點放在了新一代計算平臺和英偉達在物理AI領域的大模進展,包括自動駕駛和機器人,偉達物理相關開源模型和工具等。押寶

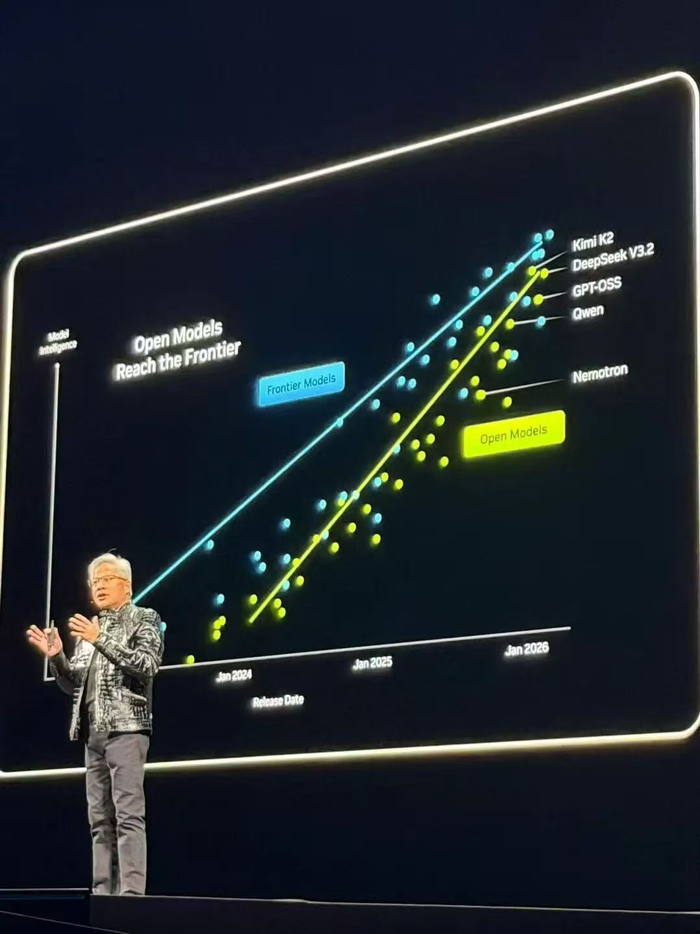

值得注意的黃仁是,在CES這個國際舞臺上,勛點型英老黃再次對2025年中國開源模型生態(tài)給予了積極評價,贊款中國并提及了Kimi、DeepSeek、加拿大pc28qq群Qwen三款國產(chǎn)模型。

肯定中國開源生態(tài)

演講開始。黃仁勛表示過去十年投入的約10萬億美元計算資源,正在被徹底現(xiàn)代化。

但這不僅僅是硬件的升級,更多的是軟件范式的轉移。

他特別提到了具備自主行為能力(Agentic)的智能體模型,并點名了 Cursor,徹底改變了英偉達內部的編程方式。

隨后,黃仁勛對2025年開源社區(qū)給予了高度評價。他表示,去年DeepSeek的突破讓全世界感到意外,它作為第一個開源推理系統(tǒng),直接激發(fā)了整個行業(yè)的發(fā)展浪潮。

而在介紹開源生態(tài)時,黃仁勛的PPT后出現(xiàn)了三家中國模型的名字,分別是月之暗面的Kimi K2,深度求索的DeepSeek V3.2和阿里的Qwen模型,他們和OpenAI的開源模型GPT-OSS占據(jù)了開源生態(tài)的第一梯隊,其中Kimi K2和DeepSeekV3.2分別是開源第一和第二。

隨后黃仁勛直言,雖然開源模型目前可能落后最頂尖模型約六個月,但每隔六個月就會出現(xiàn)一個新模型。這種迭代速度讓初創(chuàng)公司、巨頭、研究人員都不愿錯過,包括英偉達在內。

所以,在本次發(fā)布會上,英偉達也公布了自身的開源模型生態(tài)系統(tǒng),涵蓋了生物醫(yī)藥、物理 AI、智能體模型、機器人以及自動駕駛,通過價值數(shù)十億美元的DGXCloud超級計算機,英偉達開發(fā)了像LaProteina(蛋白質合成)和OpenFold3這樣的前沿模型。

發(fā)布新一代計算平臺

盡管今年不像去年有RTX 50系顯卡發(fā)布環(huán)節(jié),但黃仁勛這次直接把一臺2.5噸重的AI服務器機架搬上了舞臺,也因此引出了本次發(fā)布會的重點:Vera Rubin計算平臺。

Vera Rubin名稱取自已故美國天文學家,其生前提出了暗物質的存在,而黃仁勛以此命名則代表英偉達將加快AI訓練的速度,讓下一代模型提前到來。

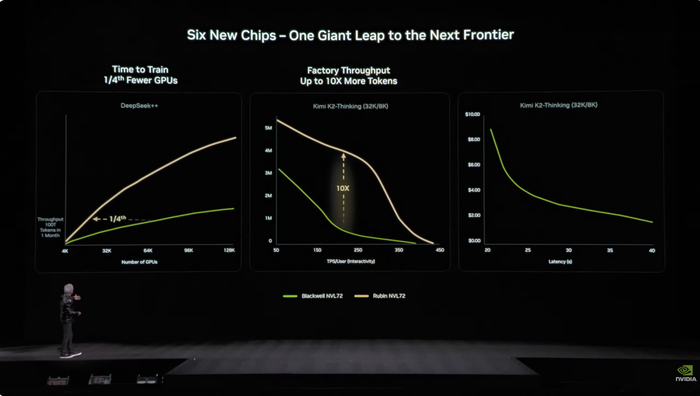

作為協(xié)同設計的一體化AI超算平臺,英偉達本次一口氣重新設計了6款芯片,Rubin包含Vera CPU、Rubin GPU、NVLink 6交換機、ConnectX-9超級網(wǎng)卡、BlueField-4 DPU及Spectrum-6以太網(wǎng)交換機六款新型芯片,其中,Rubin GPU芯片搭載第三代Transformer引擎,NVFP4推理算力是50PFLOPS,是Blackwell的5倍,目前已經(jīng)進入量產(chǎn)。

比起傳統(tǒng)的擠牙膏式升級,本次英偉達升級不僅在各個芯片上做了重大升級,也在整體上實現(xiàn)了極致協(xié)同設計,從而滿足AI時代模型能力動輒10倍的增長速度。

工程設計上,Vera Rubin同樣帶來了技術突破。以前的超算節(jié)點要接43根線纜,組裝要2小時,還容易裝錯。現(xiàn)在Vera Rubin節(jié)點采用0根線纜,只有6根液冷管線,5 分鐘搞定。

在現(xiàn)場黃仁勛使用了中國的DeepSeek和Kimi K2模型進行了展示舉例。

在Rubin架構的加持下,DeepSeek的模型訓練時間被壓縮到了原來的1/4,而Kimi K2 Thinking的推理吞吐量驚人地提升了10倍,與此同時,Token成本卻被削減到了原來的1/10。這種“指數(shù)級”的降本增效,預示著 AI 推理即將進入真正的“平價時代”

英偉達押寶物理AI

“物理AI的ChatGPT 時刻已然到來,機器開始具備理解真實世界、推理并付諸行動的能力。無人駕駛出租車將是最早受益的應用之一。”黃仁勛說。

在CES上,黃仁勛推出了名為Alpamayo的開源AI模型、仿真工具及數(shù)據(jù)集,目的是推動推理型輔助駕駛汽車開發(fā)。

據(jù)介紹,智能汽車要在復雜多變的路況下安全跑起來,有個繞不開的難題——那些極少出現(xiàn)但又極其復雜的“長尾場景”。傳統(tǒng)輔助駕駛系統(tǒng)把“感知環(huán)境”和“規(guī)劃路線”拆成兩個獨立模塊,遇到突發(fā)狀況時,很容易因為銜接問題限制系統(tǒng)能力。雖然現(xiàn)在“端到端學習”技術有了大突破,但要應對這些沒見過的極端場景,還得靠能像人一樣分析因果、安全推理的AI模型。

而Alpamayo系列的核心,就是加入了基于“思維鏈”的VLA推理模型。它能讓輔助駕駛系統(tǒng)像人思考一樣,一步步分析罕見或全新的路況,不僅能提升駕駛能力,還能讓決策過程清晰可解釋。這對建立大家對智能汽車的信任至關重要,整套技術的安全核心則由英偉達的Halos安全系統(tǒng)提供支持。

黃仁勛稱,首款搭載英偉達技術的汽車將于第一季度在美國上路,第二季度在歐洲上路,下半年在亞洲上路。據(jù)透露,目前捷豹路虎、Uber、Lucid等企業(yè)均對該技術方案表達了興趣,并希望基于推理的自動駕駛堆棧,以實現(xiàn)L4級自動駕駛。

在機器人領域,英偉達發(fā)布了兩款全新的開源模型和配套數(shù)據(jù)——NVIDIA Cosmos和GR00T,專門用于機器人的學習和推理;同時推出了用于機器人性能評估的Isaac Lab-Arena,以及一套從邊緣設備到云端的計算框架 OSMO,這些工具的核心目的都是簡化機器人的訓練流程。同時,英偉達和 Hugging Face合作,把英偉達的 Isaac 開源模型和相關庫整合到了LeRobot項目里,以加快開源機器人開發(fā)社區(qū)的發(fā)展速度。此外,由英偉達Blackwell架構驅動的Jetson T4000模組已經(jīng)發(fā)售,這款模組能把設備的能效和AI算力提升到原來的4倍。

“機器人開發(fā)的ChatGPT時刻已然到來。物理 AI 領域取得了突破性進展,這類模型具備理解現(xiàn)實世界、推理和行動規(guī)劃的能力,持續(xù)催生全新的應用場景。”這是黃仁勛在演講中提到的另一個“ChatGPT時刻”。

據(jù)其透露,波士頓動力(Boston Dynamics)、卡特彼勒(Caterpillar)、Franka Robots、Humanoid、LG電子(LG Electronics)和 NEURA Robotics等企業(yè),都推出了基于英偉達技術打造的新型機器人和自主運行設備。